隨著 AIGC 的發(fā)展,AI 繪畫逐漸進入我們的生活和工作。本文將探討 AI 繪畫技術(shù)的各個方面。從圖像生成技術(shù)邁出的里程碑事件,到對 AI 繪畫技術(shù)的深度科普,再到未來的發(fā)展趨勢分析,相信本文將能夠為大家揭示 AI 繪畫背后的神秘面紗,一起來深入了解其技術(shù)原理吧。

我會通過兩篇文章來對 AI 繪畫產(chǎn)品進行分析,第一篇主要科普圖像生成技術(shù)原理;第二篇是分析 AI 繪畫產(chǎn)品商業(yè)化落地,算是我近期對 AI 繪畫產(chǎn)品了解的一個總結(jié)輸出,以下是第一篇內(nèi)容。

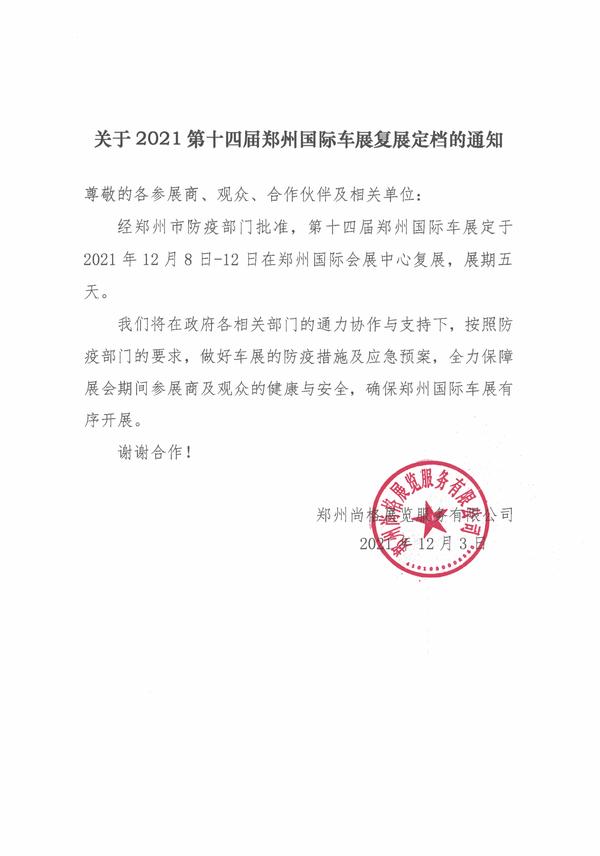

(資料圖片)

(資料圖片)

2022 年 9 月一幅名為《太空歌劇院》的畫作在數(shù)字藝術(shù)類別比賽中一舉奪冠,這個震驚四座的畫作由游戲設(shè)計師 Jason Allen 使用 Midjourney 完成,AI 繪畫進入人們的視野。

人們第一次意識到 AI 做出來的畫可以如此精美,意識到 AI 繪畫可能如同當年相機、數(shù)字繪畫的出現(xiàn)一樣,會給繪畫設(shè)計行業(yè)帶來一場深刻的變革。

這篇文章從產(chǎn)品經(jīng)理視角,了解 AI 繪畫產(chǎn)品的背后有哪些算法模型、他們的技術(shù)原理是什么?不同技術(shù)的邊界在哪里,使用場景在哪里?產(chǎn)品經(jīng)理要懂得將算法合理的組合使用,以滿足日常工作的需求,實現(xiàn)產(chǎn)品目標。

AI 繪畫發(fā)展的主要節(jié)點

AI 繪畫的底層原理

主流的圖像生成模型解析

AI 繪畫的可控性有哪些

AI 繪畫的技術(shù)研究趨勢

一、AI 繪畫發(fā)展的主要節(jié)點

1. 2012 年 AI 畫出了一只模糊的貓

吳恩達和杰夫安迪使用了 1.6 萬個 CPU 和 You Tube 上 1000 萬張貓的圖片,用時 3 天時間訓練了當時最大的深度學習模型,最終生成了一張貓臉。

雖然這張貓的圖片看起來非常模糊,而且耗時又非常久,但對當時的計算機視覺來講具有重要突破意義的嘗試,開啟了 AI 繪畫研究的全新方向。

為什么當時基于深度學習模型的 AI 繪畫那么麻煩?主要是整個模型需要利用大量標注好的訓練數(shù)據(jù),根據(jù)輸入和所對應(yīng)的預期輸出,不斷地調(diào)整模型內(nèi)部的參數(shù)進行匹配。例如生成一張 512*512 *3(RGB)的畫,要將這些像素有規(guī)律的組合,會涉及到龐大參數(shù)迭代調(diào)整的過程。

2. 2015 年文生圖重要的拐點

2015 年出了一項人工智能的重大進展——智能圖像識別。機器學習可以對圖像中的物體貼上標簽,然后將這些標簽轉(zhuǎn)化成自然語言描述。

一些研究人員產(chǎn)生了好奇,如果把這個過程反向,通過文字來生成畫面,是否也能實現(xiàn)呢?

于是他們向計算機模型輸入了一些文字,看看能產(chǎn)生什么原因,結(jié)果模型真的生成了一些結(jié)果圖片。如下圖中所示,這時產(chǎn)生了 32*32 像素的小圖片,基本很難辨別出啥,但已經(jīng)預示著無限的可能性。

3. 2021 年 OpenAI 宣布 Dalle

2021 年年初,OpenAI 發(fā)布了引發(fā)巨大關(guān)注的 DALL-E 系統(tǒng),但 DALL-E 的繪畫水平還是很一般,之所以引發(fā)關(guān)注,是因為他實現(xiàn)了輸入文字就可以繪畫創(chuàng)作的可能,比之前生成的圖片質(zhì)量高很多。

4. 2022 年開啟 AI 繪畫的元年

2 月 Disco diffusion V5 發(fā)布

在 2022 年的 2 月,由 somnai 等幾個開源社區(qū)的工程師做了一款基于擴散模型的 AI 繪圖生成器—— Disco diffusion。從它開始,AI 繪畫進入了發(fā)展的快車道,潘多拉魔盒已經(jīng)打開。

越來越多的人開始使用 Disco diffusion 創(chuàng)作作品,但是它有一個致命的缺點就是它生成的畫面都十分的抽象,這些畫面用來生成抽象畫還不錯,但是幾乎無法生成具象的人。

由于生成速度較慢,操作復雜、生成的風格相對比較抽象, 目前使用的人沒有 Stable Diffusion 和 Midjourney 那么多。

3 月 Midjouney

Midjouney 選擇搭載在 discord 平臺,借助 discord 聊天式的人機交互方式,不需要之前繁瑣的操作,也沒有 Disco diffusion 十分復雜的參數(shù)調(diào)節(jié),你只需要向聊天窗口輸入文字就可以生成圖像。更關(guān)鍵的是,Midjouney 生成的圖片效果非常驚艷,普通人幾乎已經(jīng)很難分辨出它產(chǎn)生的作品,竟然是 AI 繪畫生成的。

4 月 DALL · E 2

4 月 10 日,之前提到過的 OpenAI 推出的第二代圖像生成人工智能模型 DALL · E 2。與第一代 DALL-E 相比,DALL-E 2 在圖像質(zhì)量、生成速度和多樣性等方面都有顯著提升。影響力不及 Chat GPT,個人消費者對他沒有那么喜歡,因為他生成的圖片的風格更傾向于更一本正經(jīng),比較傳統(tǒng)一些。

7 月 Stable diffusion

7 月 29 日 一款叫 Stable diffusion 的 AI 生成器開始內(nèi)測,人們發(fā)現(xiàn)用它生成的 AI 繪畫作品,其質(zhì)量可以媲美 DALL · E 2,而且還沒那么多限制。

Stable diffusion 內(nèi)測不到 1 個月,正式宣布開源,開源讓 AI 繪畫技術(shù)的普及,也是讓領(lǐng)域能有更多人開發(fā)貢獻,加快技術(shù)的應(yīng)用發(fā)展。

二、AI 繪畫的底層原理

AI 繪畫的根源來源于人工神經(jīng)網(wǎng)絡(luò),科學家受人類神經(jīng)元啟發(fā),設(shè)計出的人工神經(jīng)網(wǎng)絡(luò)長下面這樣。

神經(jīng)網(wǎng)絡(luò)都是用數(shù)學公式表示的,沒有實體結(jié)構(gòu),圖里面的這些圈和連線是對神經(jīng)網(wǎng)絡(luò)的一種可視化呈現(xiàn),方便我們理解。

這圖中圓圈里都有一個計數(shù)器,當這個計數(shù)器接收到左邊連線傳來的數(shù)時,會進行一次簡單的計算,然后把計算結(jié)果(也是一個數(shù))輸出,通過連線傳給右邊的圓圈,繼續(xù)重復類似的過程,直到數(shù)字從最右側(cè)的圓圈輸出。

人類的不同神經(jīng)元之間連接的強度是不一樣的,有些粗一點,有些細一點。正是這些連接強度,讓我們產(chǎn)生了記憶和知識。

對于神經(jīng)網(wǎng)絡(luò)來說,也有相似的規(guī)律:圓圈和圓圈之間的連線的 " 權(quán)重 " 不同。

神經(jīng)網(wǎng)絡(luò)左側(cè)輸入一些列數(shù)字,神經(jīng)網(wǎng)絡(luò)會按照圓圈里的計算規(guī)則及連線的權(quán)重,把數(shù)字從左到右計算和傳遞,最終,從最右側(cè)的圓圈輸出一系列數(shù)字。

那如何讓神經(jīng)網(wǎng)絡(luò)畫一幅畫?

原理其實比較好理解,首先需要將圖片轉(zhuǎn)化成計算機能理解的數(shù)字語言,對于計算機而言圖片就是一串數(shù)字,每個像素顏色由 3 個 RGB 數(shù)值表示。

然后將一串數(shù)字輸入到?jīng)]有訓練過得神經(jīng)網(wǎng)絡(luò)模型,也會生成一串數(shù)字,只不過解碼后可能就是一張亂碼圖片,所以需要大量數(shù)據(jù)和不斷調(diào)整算法參數(shù)的權(quán)重,最終訓練一個能畫貓的模型。例如當輸入圖片貓或文字貓,都能轉(zhuǎn)化成一串數(shù)字到模型中,輸出一個正確的貓圖片。

圖像生成模型是在不斷演化的,從最早的 VAE 到風靡一時的 GAN,到當今的王者 Diffusion 模型,那我們接下來介紹下不同模型的技術(shù)原理是什么。

三、主流的圖像生成模型解析

1. VAE — 打開生成模型的大門

VAE 是 AE 的升級版本,AE 由一個編碼器網(wǎng)絡(luò)和一個解碼器網(wǎng)絡(luò)組成。編碼器將輸入數(shù)據(jù)映射到潛在空間中的隱變量表示,解碼器則將隱變量映射回重構(gòu)的數(shù)據(jù)空間。

如上圖,假設(shè)有一張圖像,通過編碼器提取了多種特征,比如特征 1 字體顏色、特征 2 字體粗細、特征 3 字體形狀。傳統(tǒng)的自編碼器對輸入圖像的潛在特征表示為具體的數(shù)值,比如顏色 =0.5,粗細 =0.8,形狀 =0.6。這些數(shù)值通過解碼器恢復出于原圖像相似的圖像。

那這樣的模型解決什么問題呢?

主要應(yīng)用在降維 / 可視化和去噪的場景中。

我們生活存在大量的文本、圖像、語音數(shù)據(jù),這些數(shù)據(jù)存在大量的冗余信息,理論上是可以用極少的向量來表示,所以可以用來圖像壓縮處理,這跟傳統(tǒng)的圖像壓縮技術(shù)完全不一樣。后面講到的 stable diffusion 模型就用到 AE 的潛空間來進行低維度的降噪和生成真實圖像。

在應(yīng)用場景中也能發(fā)現(xiàn),他僅適合用于重建圖像,不適用于生成新的圖像,所以有了 VAE 的誕生。

VAE 與 AE 的區(qū)別在,VAE 在編碼器輸出的分布曲線值,而非離散值,這樣的話輸入的圖像就跟壓縮向量就不是直接對應(yīng)關(guān)系,這樣就可以生成新的圖像。

如上圖,我們將每個特征通過概率分布進行表示。比如顏色的取值范圍為 [ -1,1 ] ,粗細的取值范圍為 [ -3,3 ] ,形狀的取值范圍為 [ -5,5 ] 。我們可以在范圍內(nèi)對每個特征進行取值,然后通過解碼器生成新圖像。例如給一張人臉可以生成不同表情的人臉。

VAE 不僅除了應(yīng)用在壓縮、去噪和生成新的圖像也可以應(yīng)用在圖像分割上,例如自動駕駛的道路檢測。

但 VAE 生成圖像存在局限性,生成圖像的質(zhì)量不高,存在模糊和不真實。

2. GAN — 創(chuàng)建 " 以假亂真 " 的新數(shù)據(jù)

GAN 包含了兩個模型,生成模型(Generator ) 和判別模型(Discirminator), 給生成模型隨機輸入噪聲,生成圖片;給判別模型輸入真實數(shù)據(jù)和生成的圖片,判別生成的圖片是真的還是假的。

剛開始生成器生成的圖片給判別器,判別器一看就是假的,打回去讓生成器重新生成,同樣判別模型也要提升自己的判別水平,經(jīng)過無數(shù)次的對抗,直到生成模型生成的圖片騙過判別模型。

GAN 的應(yīng)用場景有哪些?

GAN 的應(yīng)用場景非常廣泛,在圖像生成,生成不存在的人物、物體、動物;圖像修復、圖像增強、風格化和藝術(shù)的圖像創(chuàng)造等。不一一列舉,想要詳細了解的可以看鏈接:https://zhuanlan.zhihu.com/p/75789936

曾經(jīng)大紅大紫的 GAN 為什么會被 Diffusion 取代 ?

1.GAN 的訓練過程過程相對不穩(wěn)定,生成器和判別器之間的平衡很容易打破,容易導致模型崩潰或崩塌問題 ;

2. 判別器不需要考慮生成樣品的種類,而只關(guān)注于確定每個樣品是否真實,這使得生成器只需要生成少數(shù)高質(zhì)量的圖像就足以愚弄判別者 ;

3. 生成的圖像分辨率較低 ;

因此,以 GAN 模型難以創(chuàng)作出有創(chuàng)意的新圖像,也不能通過文字提示生成新圖像。

3. Diffusion — 圖像生成模型的皇冠

目前主流國內(nèi)外靠譜的圖片生成技術(shù)主要基本都是基于 Diffusion Model ( 擴散模型 ) 來進行的實現(xiàn),包括不限于 Stable Diffusion MidJourney 、 OpenAl DALL.E 、DiscoDiffusion、Google lmagen 等主流產(chǎn)品,但是實際技術(shù)在處理方面又各有區(qū)別,也導致會有不司的表現(xiàn)形態(tài),核心一方面是底層模型訓練的圖語料不同,另外一個方面是一些算法方面的微調(diào)區(qū)別。

Diffusion 模型生成圖片的過程可以理解像是石雕的過程,從一塊石頭經(jīng)過不斷的雕刻變成一件藝術(shù)作品,從一個噪點圖像不斷去噪生成一張真實圖像。

那擴散模型是怎么訓練的?

Diffusion 模型的訓練可以分為兩個部分:

前向擴散過程(Forward Diffusion Process) —— 向圖片中不斷添加噪聲,直到圖片變成完全的噪點圖片的過程。

反向擴散過程(Reverse Diffusion Process) —— 是將噪點圖片不斷的還原為原始圖片的過程。

官方給出的有 3 個訓練步驟,如下圖:

對于每張圖像先隨機生成一個長 T,T 表示從一張原始圖到高斯噪聲圖要多少次。

給原始圖片添加 T 次高斯噪聲,不同 T 時圖像添加的噪聲深度會有所不同。

將 T 和對應(yīng)的圖片放入到 UNet 模型中訓練,這樣還原圖片就能預測 T 步驟中的噪聲。

反向擴散訓練過程步驟如下圖:

采樣一張高斯噪聲圖,假如 T 設(shè)置為 1000

將高斯噪聲和 T 輸入到 UNet 模型中預測噪聲,下一步的高斯噪聲為上一步高斯噪聲減去預測噪聲,以此步驟直到 T 為 0

T 為 0 時還原最終的圖像

Diffusion 模型的大數(shù)據(jù)訓練,數(shù)據(jù)訓練來自于 LAION-5B 包含 58.3 文本 - 圖像對,并且是篩選了評分高的圖片進行訓練。通過大數(shù)據(jù)模型訓練,讓模型具有生成圖像的能力。有了生成圖像能力還不夠,需要能聽得懂需求的能力,根據(jù)文字輸入就能生成圖像。

4. CLIP —打造圖文匹配

CLIP 是 OpenAI 在 2021 年開源的模型,一種基于對比文本 - 圖像對的預訓練方法或者模型,確保計算機在文字描述和圖像之間形成互通。

在 CLIP 推出一年后,幾個開源社區(qū)的工程基于 CLIP+Diffusion 就開發(fā)了 Disco Diffusion, 后面的 midjourney 和 stable diffusion 模型都有使用 CLIP 模型。

據(jù)統(tǒng)計,CLIP 模型搜集了網(wǎng)絡(luò)上超過 4 億的 " 文本 - 圖像 " 作為訓練數(shù)據(jù),為文本生成圖像 / 視頻應(yīng)用的落地奠定了基礎(chǔ),實現(xiàn)了跨模態(tài)的創(chuàng)新。

以上圖像生成相關(guān)的模型都以解析完,那我們拿 Stable Diffusion 來進行梳理下整個圖像生成的流程是怎么樣和整體架構(gòu) , 其他圖像生成模型大致也差不多。

5. Stable Diffusion 模型結(jié)構(gòu)

Stable Diffusion 主要有三部分組成,像素空間、潛在空間 、條件機制。

像素空間 : 使用的 AE 模型將圖像壓縮到潛在空間訓練和將生成的低維向量轉(zhuǎn)化成真實圖像,這樣提升生成速度和降低算力要求。

潛在空間:Diffusion 模型在潛在空間進行加噪和去噪的訓練 , 去噪的過程需要導入條件,生成符合預期圖片。

條件機制:條件可以是文字、圖像、音頻、視頻,將條件轉(zhuǎn)化成向量值,作為 Diffusion 模型生成過程中的引導因子。

Stable Diffusion 圖像生成流如下:

通過以上擴散模型原理大致也明白 AI 生成的圖像帶有較大的隨機性,生成的每張圖像都不一樣,這種隨機性帶來的好處是無窮無盡的想象力,但同時也面臨著不可控,有點靠運氣,生成理想的圖像只能多嘗試。AI 繪畫想要擴大商業(yè)化落地,必須要解決精準可控性問題。

四、AI 繪畫的可控性有哪些

除了輸入文字、墊圖的方式還最流行的微調(diào)模型叫 Lora 和最近幾個月更新的 Controlnet 來控制圖片的生成,這幾個小模型可以理解為 Stable Diffusion 的一種插件。

1. Lora 模型

在不修改 SD 模型的前提下,教會利用少量數(shù)據(jù)訓練出只可意會不可言傳的風格,實現(xiàn)定制化需求,對算力的要求不高,模型適中在幾十 MB 大小。

Lora 必須搭配在 SD 模型上一起使用。

Lora 可以自己訓練也可以在著名的模型分享網(wǎng)站 https://civitai.com/ 上下載,有大量 Lora 模型,其中 SD 模型僅有 2000 個,剩下 4 萬個基本都是 LoRA 等小模型。

例如想要生成下面風格的汽車,我們找到這款不同角度的一些圖片作為 Lora 訓練。生成汽車的風格跟想要風格汽車很相似。

微調(diào)模型不止有 Lora 模型,還有 Textual Inversion、Hypernetwork、Dreambooth。只是 Lora 模型比較穩(wěn)定,使用門檻相對低,所以目前比較流行。

2. Controlnet 模型

Controlnet 就是控制網(wǎng)的意思,其實就是在大模型外部通過疊加一個神經(jīng)網(wǎng)絡(luò)來達到精準控制輸出的內(nèi)容。很好的解決了單純的關(guān)鍵詞的控制方式無法滿足對細節(jié)控制的需要,比微調(diào)模型更進一步對圖像生成的控制。

想要對 Controlnet 有更詳細的了解可查看如下鏈接:

https://zhuanlan.zhihu.com/p/625707834

https://mp.weixin.qq.com/s/-r7qAkZbG4K2Clo-EvvRjA

https://mp.weixin.qq.com/s/ylVbqeeZc7XUHmrIrNmw9Q

五、AI 繪畫的技術(shù)研究趨勢

1. 更強的語義理解

使用 AI 繪畫生成高質(zhì)量、精美的生成圖像需要在在 prompt 做很多努力,可見 prompt 對最終效果的影響。因此,如何降低用戶使用 prompt 的門檻,讓 AI 更能理解語義,值得研究的方向。

2. 更精準可控生成

目前可控生成是一個大火的領(lǐng)域,也有像 ControlNet 這樣的精品,可以通過輸入簡單的線稿圖、人體姿態(tài)圖、分割圖、深度圖等生成滿足條件的內(nèi)容,但距離真正的精準控制仍有差距。可喜的是,可控生成發(fā)展得越來越快,精準控制并不是遙不可及,圖像生成 AI 也會隨之拓展其應(yīng)用邊界,如一致性的視頻生成、精確的構(gòu)圖設(shè)計都會改變許多領(lǐng)域的工作方式。

最近,來自馬克斯普朗克計算機科學研究所、MIT CSAIL 和谷歌的研究者們研究了一種控制 GAN 的新方法 DragGAN,能夠讓用戶以交互的方式「拖動」圖像的任何點精確到達目標點。

這種全新的控制方法非常靈活、強大且簡單,有手就行,只需在圖像上「拖動」想改變的位置點(操縱點),就能合成你想要的圖像。

3. 運算速度更快

影響 Diffusion 在生成圖片的速度除了顯卡的性能,很重要一個原因是,每生成一張圖片需要去噪 1000 次,速度相對還不是很快,為了能在解決這個問題,OpenAI 曾在 3 月發(fā)布了一篇重磅、且含金量十足的論文「一致性模型 Consistency Models」,在訓練速度上顛覆了擴散模型,能夠 『一步生成』 ,比擴散模型更快一個數(shù)量級完成簡單任務(wù),而且用到的計算量還要少 10-2000 倍。

以上就是從圖像生成技術(shù)里程事件到對圖像生成技術(shù)的科普以及未來的發(fā)展趨勢分析,我相信通過以上內(nèi)容很容易就理解了 AI 繪畫背后的技術(shù)。下一篇對 AI 繪畫產(chǎn)品商業(yè)化落地進行分析。

作者:Rzhiyi,8 年產(chǎn)品經(jīng)理經(jīng)驗,做過 AI 皮膚檢測系統(tǒng)和 SaaS 類產(chǎn)品

本文由 @Rzhiyi 原創(chuàng)發(fā)布于人人都是產(chǎn)品經(jīng)理。未經(jīng)許可,禁止轉(zhuǎn)載。

題圖來自 Unsplash,基于 CC0 協(xié)議

提供信息存儲空間服務(wù)。

-

罕見!武漢財政局公開催債,涉及知名企業(yè)、多個區(qū)財政局|環(huán)球新要聞

頭條 23-05-27

-

劉清勇任哈爾濱電氣集團副總經(jīng)理|天天播資訊

頭條 23-05-27

-

國家網(wǎng)信辦:6.66萬個自媒體賬號,永久關(guān)閉!-世界時快訊

頭條 23-05-27

-

天邁科技與浪潮數(shù)字企業(yè)簽署戰(zhàn)略合作協(xié)議 動態(tài)

頭條 23-05-27

-

環(huán)球關(guān)注:“上市公司之家App”等成果發(fā)布

頭條 23-05-27

-

6月1日起新鄭恢復機動車尾號限行處罰

頭條 23-05-27

-

“牛散”再度被罰!用18個證券賬戶操縱一只股票,獲利近1600萬元-全球焦點

頭條 23-05-27

-

3家A股房企鎖定“面值退市”,這些房企也拉響警報

頭條 23-05-27

-

天天觀天下!近600億規(guī)模基金公司股權(quán)變更

頭條 23-05-27

-

總投資278億元,中國石化洛陽百萬噸乙烯項目開工_環(huán)球頭條

頭條 23-05-27

-

環(huán)球快資訊:聚焦“多實惠+好服務(wù)”,拼多多今年一季度總營收376.371億元

頭條 23-05-27

-

河南山東部分地區(qū)或現(xiàn)同期少見降雨 江南華南提前體驗盛夏悶熱 今日播報

頭條 23-05-27

-

國家統(tǒng)計局:1~4月份全國規(guī)上工業(yè)企業(yè)利潤下降20.6%

頭條 23-05-27

-

【快播報】隔夜歐美·5月27日

頭條 23-05-27

-

全球看熱訊:商務(wù)部部長王文濤會見美國貿(mào)易代表戴琪

頭條 23-05-27

-

商務(wù)部部長王文濤會見世貿(mào)組織總干事伊維拉 快看

頭條 23-05-27

-

立方風控鳥·早報(5月27日)

頭條 23-05-27

-

國際貨幣基金組織略微調(diào)高2023年全球增長預期

頭條 23-05-27

-

房貸利率會上調(diào)?業(yè)內(nèi)人士:誤讀|環(huán)球微速訊

頭條 23-05-27

-

加速基建!鄭州新國際會展中心、鄭州國際文化交流中心,今明兩年將相繼落成

頭條 23-05-26

-

利率2.75%!北京銀行再發(fā)100億元小微金融債_天天快播報

頭條 23-05-26

-

全球資訊:上期所舉行商品期權(quán)研討會,積極推進更多期權(quán)品種上市

頭條 23-05-26

-

立方風控鳥·晚報(5月26日)

頭條 23-05-26

-

新規(guī)出臺!整治“霸王條款”等不公平格式條款_當前滾動

頭條 23-05-26

-

逾三百位專家企業(yè)家齊聚鄭州,共話中原鋼材產(chǎn)業(yè)發(fā)展

頭條 23-05-26

-

財政部:前4個月國企利潤總額14388.1億元,同比增長15.1%

頭條 23-05-26

-

西安市人才發(fā)展基金啟動 首期規(guī)模5億元

頭條 23-05-26

-

華蘭疫苗:河南驊盈擬減持不超2%股份|當前報道

頭條 23-05-26

-

剛剛!河南公布728家省定重點上市后備企業(yè) | 名單

頭條 23-05-26

-

豫地科技集團所屬36家二級公司揭牌|每日熱文

頭條 23-05-26

-

4月我國外匯市場總計成交20.14萬億元人民幣

頭條 23-05-26

-

最新數(shù)據(jù)!前4月新增退減緩稅費4689億,誰受益最大?_天天日報

頭條 23-05-26

-

鄭州交運集團等24家高風險運輸企業(yè)被約談-世界熱點評

頭條 23-05-26

-

世界快資訊:鄭州至南陽高速新進展!鄭許段施工圖獲批,預算121億元

頭條 23-05-26

-

【當前熱聞】華福證券擬引入多家戰(zhàn)略投資者,持股比例合計不超過20%

頭條 23-05-26

-

5311家!河南最新一批入庫科技型中小企業(yè)名單公布

頭條 23-05-26

-

天天速看:聚焦戰(zhàn)略配售核心命題,專精特新豫企與一線投資機構(gòu)面對面

頭條 23-05-26

-

1209套!鄭州新一批人才公寓5月27日上線配租 通訊

頭條 23-05-26

-

興業(yè)銀行鄭州分行:以金融之筆添彩美麗河南

頭條 23-05-26

-

觀速訊丨大連萬達商管就四大市場傳聞發(fā)布澄清說明

頭條 23-05-26

-

方正證券:“方正聯(lián)合交易終端APP”是假冒方正證券的APP

頭條 23-05-26

-

法院判了!特斯拉車頂維權(quán)女車主,敗訴!

頭條 23-05-26

-

河南省政府新任免一批干部 動態(tài)焦點

頭條 23-05-26

- AI 繪畫技術(shù)原理解析 焦點訊息2023-05-27

- 重點聚焦!防大病管慢病促健康,融合創(chuàng)新引2023-05-27

- 【世界獨家】【世界說】道德淪喪且無所作為2023-05-27

- 世界最資訊丨精神風貌是成語嗎_精神風貌怎2023-05-27

- 【全球快播報】龍佰集團子公司獲22.72億股2023-05-27

- 罕見!武漢財政局公開催債,涉及知名企業(yè)、2023-05-27

- 南昌一地演出彩排舞臺背景屏倒塌 9名幼兒2023-05-27

- 傳播謠言、蹭炒熱點、假冒仿冒……“清朗”2023-05-27

- 全國體操錦標賽:奧運冠軍劉洋吊環(huán)摘金 邱2023-05-27

- 安徽多地暴雨積水嚴重 被困人員和車輛緊急2023-05-27

- 注意防范!鄭州這些區(qū)域發(fā)生地質(zhì)災(zāi)害的可能2023-05-27

- 焦點精選!電子狗電腦一鍵升級方法(電子狗2023-05-27

- 當前熱文:旅客稱在新加坡遭南航柜臺辱罵,2023-05-27

- 特斯拉車頂維權(quán)女敗訴:馬斯克曾放話永不妥2023-05-27

- 即時焦點:《熱血當歌》赴滬角逐荷花獎2023-05-27

- 世界觀速訊丨開“運”隨手拍丨淮安攝影師眼2023-05-27

- 如何打造高技能人才培訓基地?一起聽科創(chuàng)的2023-05-27

- 北京加快推動建設(shè)具國際影響力互聯(lián)網(wǎng)3.0創(chuàng)2023-05-27

- 環(huán)球看熱訊:加速東北地區(qū)路網(wǎng)建設(shè) 沈陽至2023-05-27

- 高校畢業(yè)生規(guī)模創(chuàng)新高 廣西多措促就業(yè)2023-05-27

- “新技術(shù)+新模式”賦能農(nóng)業(yè) 科技助農(nóng)播種2023-05-27

- 劉清勇任哈爾濱電氣集團副總經(jīng)理|天天播資2023-05-27

- 國家網(wǎng)信辦:6.66萬個自媒體賬號,永久關(guān)閉2023-05-27

- 知乎發(fā)布最新大模型應(yīng)用“搜索聚合”,即日2023-05-27

- 中央氣象臺:沿淮地區(qū)等地將有較強降雨2023-05-27

- 注意防范!鄭州市發(fā)布地質(zhì)災(zāi)害氣象風險黃色2023-05-27

- 中央氣象臺繼續(xù)發(fā)布暴雨藍色預警:四川、河2023-05-27

- 中央氣象臺5月27日18時繼續(xù)發(fā)布大霧黃色預2023-05-27

- “中國反恐部隊”“戰(zhàn)略導彈部隊”等假冒賬2023-05-27

- 自然資源部與中國氣象局5月27日18時聯(lián)合發(fā)2023-05-27

精彩推薦

閱讀排行

- 當前通訊!河北一派出所對煙花爆竹取樣鑒定時發(fā)生爆炸,已致4人死亡2人失聯(lián)

- 周迅毛不易作客“蘑菇屋”,默契對話同頻養(yǎng)生_焦點觀察

- 《乘風2023》迎來“二公”,謝娜龔琳娜孫悅唱跳嗨翻全場|新資訊

- “大學生掏鳥案”當事人閆嘯天已經(jīng)出獄,父親:孩子很累想讓他休息|全球即時看

- 河南“大學生掏鳥案”當事人出獄,家人安排團圓飯-全球熱消息

- 全球新資訊:大學生掏鳥案當事人閆嘯天刑滿釋放,已回到家中休息

- 降雨持續(xù)!今日全省大部有陣雨、局部暴雨 有短時強降水、短時大風等強對流天氣|全球最新

- 突發(fā)!危急!鋼筋貫穿身體,醫(yī)護人員緊急開展7小時生死營救

- 律師解讀上海兩司機開“斗氣車”:涉嫌危害公共安全 環(huán)球熱消息

- 26歲女子吃火鍋后嗓子疼,就診到去世僅10分鐘!醫(yī)生:這種情況要警惕!